Flowers et Mnemosyne : au cœur de l'IA

Flowers : l’équipe-projet est pionnière de la "curiosité artificielle", une approche de l’intelligence artificielle par apprentissage autonome intrinsèquement motivé dont le but est de mettre au point des technologies éducatives au service de l’apprentissage humain.

Mnemosyne : l’équipe-projet développe des modèles de réseaux de neurones. Ils miment les mécanismes cérébraux de la prise de décision dans un monde ouvert et changeant et correspondant aux fonctions exécutives à mettre en œuvre pour détecter le changement et s'y adapter ; ceci amène l'équipe à considérer différents mécanismes cognitifs comme l'évaluation émotionnelle des situations, la prise de décision simple et son automatisation, la décision motivée, la planification, le raisonnement, l'attention et la mémoire de travail. Ces travaux sont menés avec des neurobiologistes pour le déchiffrage de ces circuits et la mise au point de modèles neuronaux adaptatifs. Ils visent la meilleure compréhension du cerveau et de la cognition, avec en particulier des applications médicales (Parkinson, TOC, addiction, Alzheimer, etc.). Ils ont également des retombées dans le domaine de l'apprentissage automatique (proposition de nouveaux algorithmes bio-inspirés) et de l'intelligence artificielle (modèles de décision cognitivement plausibles) avec des transferts vers le monde socio-économique (applications industrielles avec prise de décision, planification, organisation temporelle du comportement, traitement du langage, robotique, comportement autonome, sciences de l'éducation).

CQFD et RealOpt : science de la donnée et optimisation

CQFD : l'équipe-projet développe un savoir-faire en optimisation de systèmes dynamiques et aléatoires. Les thématiques scientifiques abordées dans l’équipe relèvent de l’apprentissage supervisé, non supervisé, l’apprentissage par renforcement, les algorithmes stochastiques, la programmation génétique, les algorithmes évolutionnaires à la fois sur les plans théoriques, méthodologiques et applicatifs ... et sont appliqués notamment au domaine de la santé (réglage automatique d’implants cochléaires, classification de signaux EEG) et de la défense (filtrage stochastique, contrôle adaptatif, …).

RealOpt : l’équipe-projet travaille sur des problématiques d'optimisation combinatoire. Il s’agit de trouver le plus rapidement possible une solution à un problème complexe parmi un très grand ensemble de solutions. De nombreux problèmes d’intelligence artificielle se formulent comme des problèmes d’optimisation comme les problèmes de clustering. Les techniques développées par RealOpt ont permis la résolution de problèmes complexes de planification stratégique posés par des PME et des grands groupes comme la SNCF ou EDF.

Geostat et Potioc : image et signal, interfaces humain-machine

Geostat : l'équipe-projet développe des méthodes d'analyse des signaux naturels complexes en utilisant, entre autres, des analogies et des modélisations issues de la physique statistique. Ces modèles rendent compte des phénomènes critiques (exemple: changement de phase) rencontrés en analyse des grandes quantités de données. L'équipe mène des recherches en classification et analyse des signaux en sciences de la terre et en santé ; nous travaillons sur une nouvelle classe de modèles prédictifs et leur estimation à partir des données.

Potioc : l'équipe-projet explore et conçoit des outils d'intelligence artificielle pour l'analyse et la classification des signaux cérébraux (en particulier des signaux électroencéphalographiques - EEG) dans le cadre de ses recherches sur les interfaces cerveau-ordinateur, permettant à un utilisateur ou une utilisatrice d'interagir avec un ordinateur uniquement grâce son activité cérébrale. Pour ce faire, elle étudie et développe des outils d'apprentissage artificiel pour "débruiter", caractériser, et classifier de manière robuste et adaptative des signaux EEG. Elle utilise et développe également des outils d'IA pour modéliser l'utilisateur en interaction avec un système, notamment son état et ses préférences, afin de lui fournir une interaction adaptée et adaptative, pour maximiser l'efficience et l'efficacité de l'interaction. Ces diverses technologies visent des applications telles que la rééducation motrice (ex: rééducation post AVC - accident vasculaire cérébral) ou cognitive (ex : amélioration de la vigilance ou de l'attention) par BCI - Brain Computer Interface, ou encore des systèmes éducatifs adaptés à l'utilisateur.

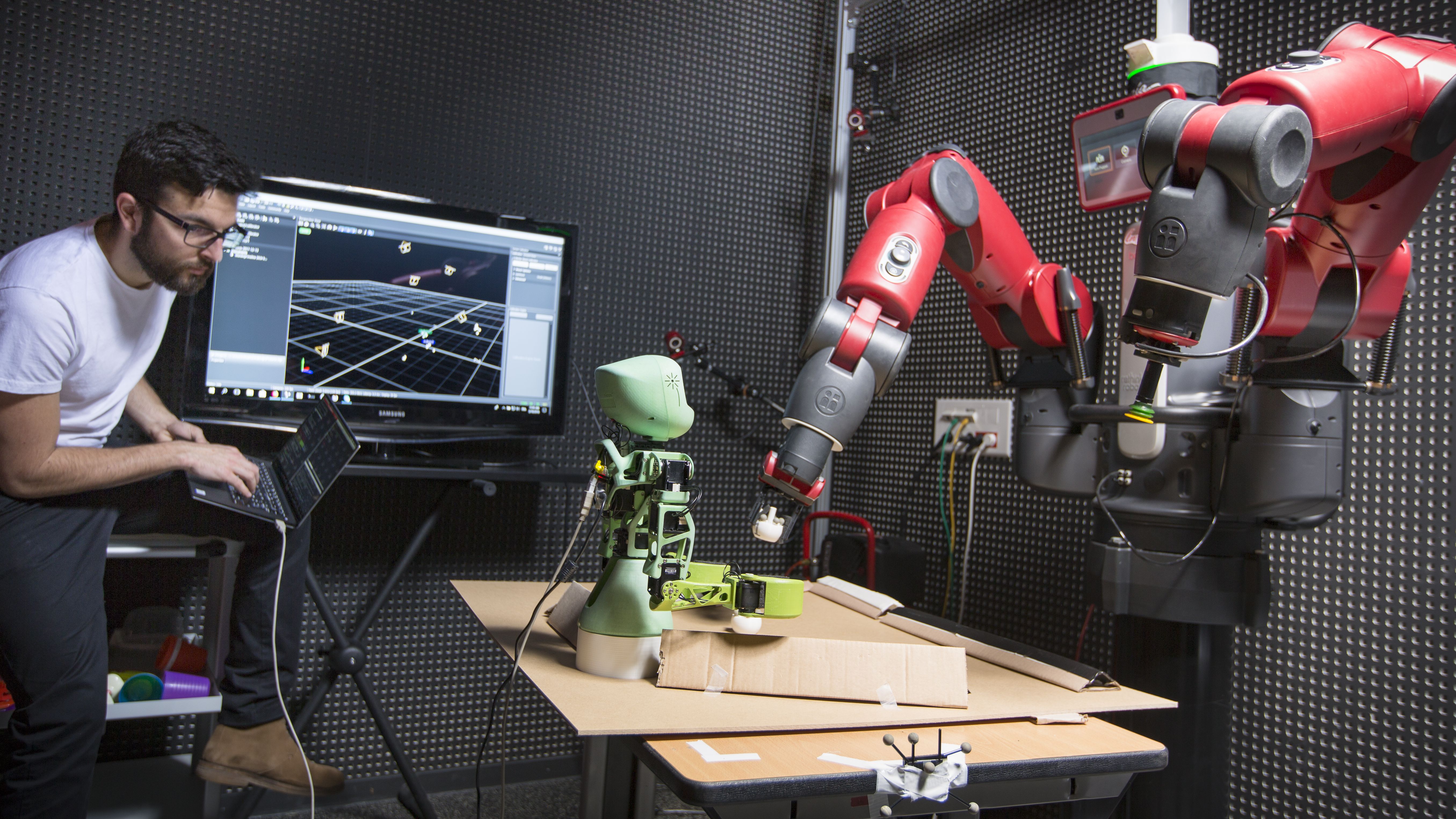

Auctus : robotique

Auctus : l'équipe s'intéresse à la collaboration entre l'humain et le robot dans le cadre d'applications industrielles. Pour collaborer au mieux, il est nécessaire de maîtriser les capacités d'autonomie et d'interaction du robot à travers quatre axes complémentaires : un premier sur la capacité à analyser l'environnement grâce à des capteurs, par exemple de vision ou de pression, un deuxième sur la coordination sensorimotrice fine, qui nécessite la maîtrise des lois de commande, un troisième sur l'analyse et l'interprétation de l'activité humaine, notamment au niveau des gestes, et enfin un dernier sur les modalités de la collaboration humain-robot, avec des problématiques de partage des représentations, de partage d'autorité, et plus généralement d'aide à la décision, sans oublier les problématiques d'acceptabilité et d’éthique.

Tadaam, Hiepacs et Storm : Optimisation spécifique, architectures et composants matériels

Hiepacs : l'équipe-projet s'intéresse à l'optimisation des stratégies d'ordonnancement pour les frameworks de DeepLearning comme TensorFlow et PyTorch. L’objectif est à la fois d’augmenter le parallélisme et de limiter la consommation de mémoire. L'équipe développe des algorithmes parallèles efficaces en algèbre linéaire et tensorielle pour des clusters de machines hybrides (CPU+GPU). Ces algorithmes sont appliqués dans le cadre de la classification pour le metamarcoding.

Storm : l’équipe-projet développe des outils et des méthodes pour le calcul haute performance pour permettre une meilleure utilisation des machines parallèles. Storm s’intéresse notamment aux problématiques d'expression du parallélisme, de mise en œuvre et notamment d'ordonnancement des calculs et des communications, d'exécution sur des architectures hétérogènes, mêlant CPU, GPU et accélérateurs.

Tadaam : l’équipe-projet développe également des outils et des méthodes pour le calcul haute performance pour permettre une meilleure utilisation des machines parallèles. Les outils développés peuvent être utilisés pour l'optimisation des entrées-sorties (stockage et lecture des grandes masse de données pour l'apprentissage) et les communications de ces masses de données dans les supercalculateurs.

Carmen, Monc, Pléiade et Sistm : biologie et santé

Carmen : l'équipe-projet a pour objectif d'améliorer la compréhension et le traitement des pathologies du rythme cardiaque liées au fonctionnement électrique du cœur, à travers le développement de modèles et d'outils de simulation efficaces et précis et l'utilisation des signaux électriques disponibles pour améliorer les diagnostics. En complément des outils classiques de modélisation et de simulation, Carmen utilise et développe des outils d'IA pour concevoir des modèles réduits pour restreindre l'espace des paramètres et effectuer des simulations en temps réel (ex: utilisation d'un cathéter endocardique lors d'une ablation, ou simulation de la propagation de l'onde électrique), résoudre des problèmes inverses pour la reconstruction et l'interprétation de signaux électriques, par exemple avec des réseaux de neurones ou des techniques d'optimisation, et plus généralement pour incorporer les données expérimentales ou médicales dans nos modèles.

Monc : l'équipe-projet développe des algorithmes d'intelligence artificielle, dans le cadre de ses recherches sur le cancer, pour aider au diagnostic afin d'améliorer le suivi de la maladie. Ces approches servent à mieux personnaliser les modèles de progression du cancer à partir de populations de patients et au traitement des données médicales. L'équipe s'intéresse également à la robustesse de ces méthodes.

Pléiade : l'équipe-projet développe des algorithmes de reconnaissance de forme et d'apprentissage automatique, afin de découvrir des patterns dans la diversité génétique d'organismes et d'en construire des réseaux de fonctions en interdépendance et d'organismes en interaction. Pléiade dérive des modèles de processus cellulaires et écologiques, et construit des cadres logiciels pour des applications en écologie, évolution et biotechnologies.

Sistm : l'équipe-projet développe et utilise des méthodes d'apprentissage statistique appliquées en santé principalement en immunologie clinique et vaccinologie. À titre d'illustration, les objectifs applicatifs sont d'accélérer le développement de vaccins, comprendre et prédire leur effet, optimiser leur administration. Pour cela, l'équipe met en oeuvre des approches d'apprentissage statistique supervisé et non supervisé pour l'analyse de données en grande dimension (multiomiques) issues de populations de participants à des essais cliniques ou de cohortes observationnelles. Les prédictions et optimisations individuelles font appel à des modèles dynamiques (ODE) populationnels. L'équipe participe également à l'évaluation en population (essais cliniques) des prédictions et approches développées.

Cardamom et Memphis : Modélisation

Cardamom : pour l'équipe-projet, spécialiste de la conception de méthodes numériques robustes et efficaces pour la simulation d’écoulements fluides avec des fronts complexes, l'apprentissage constitue l'étape essentielle pour la construction de métamodèles et de modèles simplifiés permettant de reproduire de manière fiable des surfaces de réponse lors de la variation de paramètres physiques.

Memphis : pour l'équipe-projet dont l'objectif est de mettre en œuvre de nouveaux modèles numériques sur les infrastructures de calcul intensif et de les rendre disponibles pour répondre à des besoins industriels réels, la convergence entre modélisation et données est le nouvel horizon de la simulation numérique. Cette nouvelle approche se décline en deux volets : l’apprentissage de l’espace solution d’un problème physique d’une part et d’autre part la conception de modèles de fermeture ad hoc qui combinent des mesures distribuées et des approches de régression non linéaires.